متا تگ Robots چیست؟ + بررسی کاربرد Meta Robots Tags در سئو

متا تگ Robots یکی از ابزارهای مهم در بهینهسازی موتورهای جستجو (SEO) است که به وبمستران کمک میکند تا کنترل بیشتری بر رفتار رباتهای جستجو درباره صفحات وب خود داشته باشند. با استفاده از این تگ، میتوان به موتورهای جستجو بگویید که صفحه مورد نظر چگونه در نتایج جستجو نمایش داده شود و آیا لینکهای موجود در آن دنبال شوند یا نه. بهطور کلی برای پاسخ به این سوال که متا تگ Robots چیست و چه کاربردی دارد، در ادامه این مقاله از نادین وب همراه ما باشید.

انواع متا Robots چیست ؟

دو نوع اصلی از دستورات متا روبات وجود دارد: تگ متا و تگ x-robots. هر پارامتری که بتوان از آن در تگ متا ربات ها استفاده کرد ، در تگ x-robots هم قابل استفاده هستند.

X-robots-tag

متا تگ ها به شما امکان می دهد که index کردن یک صفحه کنترل کنید، تگ x-robotsعلاوه بر کنترل ایندکس کردن یک صفحه، کنترل بخشی از هدر HTTP تا یک بخش خاص در سایت را به شما میدهد.

هرچند شما میتوانید از تگ x-robots برای دستورالعملهای ایندکس کردن، دقیقا مثل متا تگ ها استفاده کنید، اما تگ x-robots ، انعطافپذیری زیاد و قابلیت های چشمگیری دارند که تگ متا روباتها این کار را نمیکند و شما به وسیله ی آن ها میتوانید حتی crawl فایل های غیر html را کنترل کنید.

برای استفاده از تگ x-robots، باید به فایل php.، htaccess. و سرور هدر وب سایت خود دسترسی داشته باشید.

در اینجا چند مورد استفاده وجود دارد که چرا ممکن است از تگ x-robots استفاده کنید:

- کنترل ایندکس کردن محتوایی که به صورت HTML نوشته نشده است (مثل ویدیو ها )

- جلوگیری از ایندکس شدن یک المان خاص که به صورت HTML نوشته نشده درحالی که از ایندکس نشدن کل صفحه جلوگیر نشود

- اگر به HTML صفحه (مخصوصاً به بخش <head>) دسترسی ندارید یا اگر سایت شما از یک سربرگ global استفاده می کند که قابل تغییر نیست، فهرست بندی را کنترل کنید.

- افزودن قوانین خاص به ایندکس شدن یا نشدن یک صفحه (مثلاً اگر کاربر بیش از 20 بار نظر داده است، صفحه ی مشخصات کاربر را ایندکس کند)

متا تگ Robots چیست؟

متا تگ Robots درواقع یک کد HTML است که به ربات های موتور جستجو گوگل می گوید که چگونه محتوای صفحه را crawl کنند، index کنند و به مخاطب نشان دهند. بهطور کلی متا تگها در بخش head قرار میگیرند. البته توجه داشتهباشید که head و header با یکدیگر متفاوتند.

میتوانید از متا تگ در هر صفحه از سایت استفاده و آن ها را جداگانه تنظیم کنید و یا از بخش تنظیمات SEO سایت، متا تگ ها و مقادیر آن ها را برای چندین صفحه تنظیم کنید و به طور همزمان از آن استفاده کنید.

برای پیدا کردن متا تگ Robots در یک صفحه، به سادگی روی یک صفحه سایت کلیک راست کرده، روی “View Source” کلیک کنید و سپس کلمه ی”Robots” را سرچ کنید. نتیجه جستجوی شما باید چیزی شبیه موارد زیر باشد:

<meta name=”robots” content=”noindex” />

<meta name=”googlebot” content=”noindex” />

<meta name=”googlebot-news” content=”noindex” />

<meta name=”slurp” content=”noindex” />

<meta name=”msnbot” content=”noindex” />

در این مثال، خط خط اول برای همه رباتهای گوگل اعمال میشود، در حالی که در 4 خط ، دستورات فقط برای ربات های خاصی اعمال میشود. در این مثال خاص، تگ متا به موتورهای جستجو می گوید که صفحه را ایندکس نکنند.

اهمیت متا تگ robots از آن جهت هست که یک لایه حفاظتی اضافی به فایل robots.txt اضافه می کند. فرض کنید یک صفحه در سایت خود دارید که به هر دلیلی نمیخواهید آن صفحه را index کنید؛ هنگامی که یک خزنده گوگل یک لینک خارجی را دنبال می کند و در یکی از صفحات شما قرار می گیرد، همچنان می تواند آن صفحه را crawl و indexکند چون فایل robots.txt را ندیده است. متا تگ robots در همچین مواردی از وقوع این crawl و index شدن صفحه جلوگیری می کند.

متا تگ Robot ها چگونه کار می کند؟

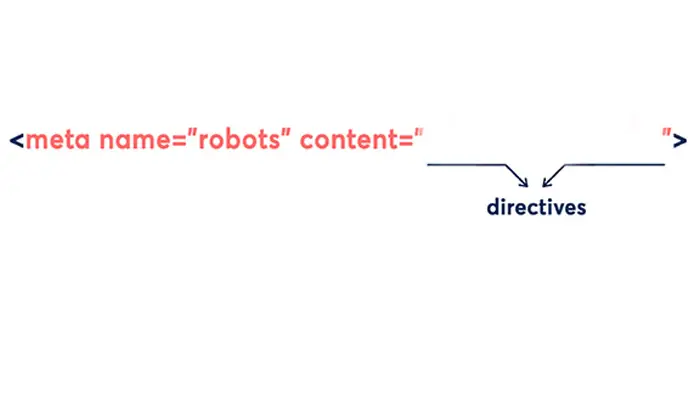

همانطور که در تصویر مشاهده میکنید، متا تگ دو قسمت دارد:

قسمت name ، اسم ربات و کنترل کننده هایی(عاملهای کاربر یا user-agents که به آنها UA نیز گفته میشود) که به آن دستور میدهید را مشخص میکند و برخلاف robots.txt. نمیتوانید از هر اسمی برای مشخص کردن همه ی ربات ها استفاده کنید و برای انتخاب همه ی آن ها فقط کافی است یک اسم بنویسید “robots”

قسمت دوم، “Content”= جایی است که به ربات ها می گویید چه کاری انجام دهند. که value های مختلفی برای آن وجود دارد.

چه مقادیری برای متا تگ Robots وجود دارد؟

شما میتوانید مقادیر متنوعی به ربات تگ اضافه کنید که هر کدام از آن ها نتایج متفاوتی دارد . در اینجا چند مورد از مهم ترین و کاربردی ترین آن ها را ذکر کرده ایم:

- Index: به موتورهای جستجو می گوید که صفحه مورد نظر را index کنند یا نه. این کار در نگاه اول ممکن است بی معنی به نظر برسد، زیرا “Index” صفحات پیش فرض گوگل هست، اما برای کسانی که می خواهند فقط تعداد مشخصی از موتورهای جستجو صفحه را “Index” کنند، می تواند مفید باشد.

- NoIndex: به موتورهای جستجو می گوید که صفحه را “Index” نکند تا در نتایج جستجو ظاهر نشود. این کار معمولا برای صفحاتی که دائما محتوای آن درحال تغییر است مثل سبد خرید فروشگاه ها استفاده می شود.

- NoImageIndex: به موتورجستجو گوگل میگوید که تصاویر موجود در یک صفحه را Index نکنند.

- None: این روش معمولا به عنوان میانبر برای “noindex, nofollow” کار می کند و به موتورهای جستجو میگوید که صفحه را نادیده بگیرند و وانمود کنند که هرگز آن را ندیدهاند.

- Follow: به موتورهای جستجو میگوید که حتی اگر صفحه ایندکس نشده باشد، خزنده گوگل باید همه لینک های یک صفحه را برررسی و ارزش پیوند (Link Equity) را به صفحات لینک داده شده منتقل کند.

- NoFollow: به موتورهای جستجو می گوید که به هیچ وجه لینک های موجود در یک صفحه را دنبال نکند. و ارزش پیوند (Link Equity) را به صفحات لینک داده شده منتقل نکند.

- NoArchive: به موتورهای جستجو می گوید که نباید لینک های کش شده به این صفحه را در صفحه ی نتایج گوگل نشان دهند

- NoCache: درواقع همان “NoArchive” است اما فقط در اینترنت اکسپلورر و فایرفاکس انجام میشود.

- NoSnippet: جلوی موتورهای جستجو را از نشان دادن بخشی از صفحه در نتایج جستجو را میگیرد. همچنین از کش کردن صفحه توسط آنها جلوگیری می کند.

- NoTranslate: به موتورهای جستجو می گوید که نسخه های ترجمه شده صفحه را در نتایج جستجو ارائه نکنند.

- Unavailable_after: به موتورهای جستجو می گوید که صفحه را پس از تاریخ مشخصی در نتایج جستجو نمایش ندهند.

Robots.txt چیست و چه تفاوتی با متا تگ Robots دارد؟

Robots.txt یک فایل متنی است که مدیران وبسایت، برای آموزش به رباتهای موتورهای جستجو ایجاد میکنند که چگونه صفحات را در وبسایت crawlکنند. فایل robots.txt بخشی از پروتکل حذف روبات ها (REP) است،که “REP” گروهی از استانداردهای وب است که نحوه خزیدن ربات ها در وب، دسترسی و ایندکس محتوا و ارائه آن محتوا به کاربران را تنظیم می کند.

فایلهای robots.txt نشان میدهند که آیا برخی از user-agents مثلا ربات های گوگل میتوانند یا نمیتوانند بخشهایی از یک وبسایت را بخزند. این دستورالعملهای خزیدن با disallowing و allowing مشخص میشود.

فورمت فایلهای robots.txt معمولا به صورت زیر است:

User-agent: [user-agent name]Disallow: [URL string not to be crawled]

و در اکثر سایت های وردپرسی با url زیر میتوانید فایلهای robots.txt را پیدا کنید:

Robots.txt file URL: www.example.com/robots.txt

فایلهای Robots.txt برای کنترل ایندکس کردن یک بخش کامل از یک سایت، مانند یک دسته، مناسب هستند، در حالی که یک متا تگ در غیر مجاز کردن فایلها و صفحات تکی کارآمدتر است. میتوانید همزمان از تگ متا روبات و فایل robots.txt استفاده کنید.

متا تگ Robot چه تاثیری در سئو سایت دارد؟

شما میتوانید از متا تگ ها برای کمک به موتورهای جستجو استفاده کنید تا سایت شما را به طور کارآمد تر crawl کنند. رباتهای جستوجو بودجه خزیدن (crawl budget) محدودی دارند، بنابراین نمیتوانند همه ی صفحات شما را crawl کنند و ممکن است تمام وقت خود را صرف خزیدن صفحاتی کنند که به رتبهبندی آنها اهمیتی نمیدهید، در حالی که مهمترین صفحات شما را نادیده بگیرند. مسدود کردن ایندکس کردن این صفحات بیاهمیت به هدایت خزندهها به صفحات ارزشمندتر شما کمک میکند.

اگر صفحهای دارید که تعداد زیادی از لینک ها را به دست آورده است، اما نمیخواهید ایندکس شود، از دستورالعمل فالو استفاده کنید تا آن اعتبار صفحه را به سایر صفحات سایت خود منتقل کنید.پس به طور کلی فایده ی اصلی متا تگ Robot برای سایت شما بستگی به نحوه ی استفاده ز آن دارد.

سوالات متداول

چند نوع متا Robots وجود دارد؟

بهطور کلی دستورات متا روبات در 2 نوع اصلی وجود دارند که عبارتند از متا تگ Robots و تگ x-robots. هر پارامتری که بتوان از آن در Robots Meta tags استفاده کرد ، در تگ x-robots هم قابل استفاده هستند.

متا تگ Robots چه کاربردی دارد؟

تگ “meta robots” در HTML برای کنترل رفتار رباتهای جستجو درباره صفحات وب استفاده میشود. این تگ به وبمستران امکان میدهد دستوراتی را به رباتهای جستجو ارسال کنند که تعیین میکنند صفحه مورد نظر چگونه شناسایی و نمایش داده شود.

آیا متا تگهای Robots در سئو سایت تاثیرگذار هستند؟

با توجه به کاربرد متا تگ robots بدیهی است که این متا تگ تاثیر بسیار زیادی در سئو وبسایت شما دارد، درواقع این متا تگ باعث کرال کارآمدتر شده و وبسایت شما نزد گوگل بهنیهتر میشود.

بیشتر بخوانید:

بدون دیدگاه